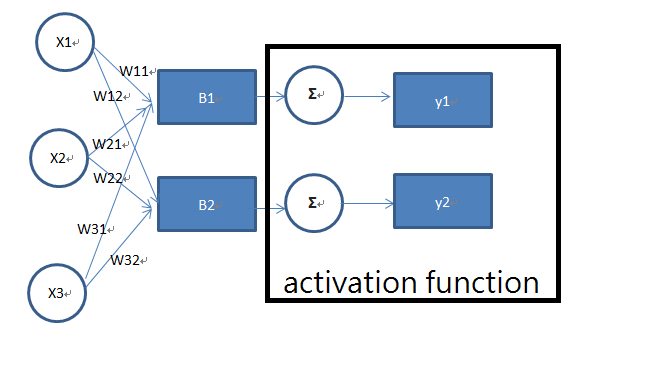

今天要接續昨天講解的深度學習,在昨天講解都是以單一接收神經元的資料,今天要來講解如何以矩陣運算模擬多個神經元傳輸,如下圖:

公式:

深度學習有相當多學習方式,像是Multilayer perceptron(MLP)、Backpropagation...之後會繼續詳細介紹,並結合今年相當常聽到又好用的Tensorflow、Keras模組範例。

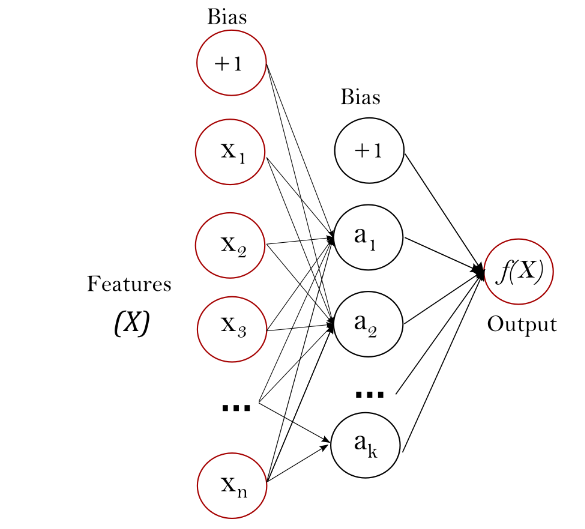

圖片引用SKlearn:https://scikit-learn.org/stable/modules/neural_networks_supervised.html

根據上圖,可以很清楚明白,MLP就是以模擬神經網路來實作的